Q&答:微软全球媒体和娱乐战略总监Simon Crownshaw谈到了Gen AI

在这个内容广泛的采访中 Simon Crownshaw, Microsoft’s worldwide media and entertainment strategy director,我们讨论微软的客户是如何利用的 生成的人工智能 在流媒体工作流程的所有阶段,以及他们如何在内容交付中使用它,并在一系列用例中增强用户体验. Crownshaw还深入探讨了微软是如何构建资产管理架构的,以及元数据在有效的大语言模型(llm)中扮演的关键角色。, 最大化可用数据的价值.

Nadine Krefetz: 你的客户是如何谈论生成式人工智能的,他们是从哪些用例开始的?

西蒙Crownshaw: Asset management, user experience, video 交付, and compression. 为什么所有这些模型必须一起工作,为什么我们的客户考虑的不仅仅是一种模型,这是一个共同的线索, 但许多.

Krefetz: 为什么 元数据 如此的重要?

Crownshaw: 今天,大多数人找不到任何东西. 我们需要做更多的自动化内容检索, 无论是新闻还是流媒体平台上的直播内容, 以便更快地找到所有的东西. 如果你看一下我们用 nbc环球和康卡斯特围绕着奥运会 还有艾尔·迈克尔斯的画外音, 例如, 将所有这些资产带着正确的标签放入Cosmos数据库,使观众能够快速地进行自然语言搜索以找到一些东西.

When you bring in the models and the cognitive services to overlay the voice, 如果所有元数据都一致地根据能够与大型语言模型协同工作的数据模型进行组织,则会容易得多. 当你不得不从一些随机的Excel文件或所有内容中可能存在的不一致的元数据中提取数据时, 这很难做到.

Krefetz: 你能描述一些资产管理架构吗?

Crownshaw: 我们考虑数据摄取层时,考虑的是如何引入内容——原始媒体文件, 元数据摄取. To understand how to associate the media with the right descriptions, 我们将通过从视频中提取帧并使用Apache或将其放入文本来处理所有不同的元素 TensorFlow. 然后生成AI部分就建立在上面.

用于场景检测模型, you want to understand how to recognize and categorize different types of 场景. 你可以做一个序列到序列类型的片段, 就像GPT变压器一样, 要懂得如何把那些简洁的文字总结出来, 字幕, 或者把脚本放在正确的地方. 通常, we would do that through some deep learning frameworks.

Some of the tools are available on Azure, such as the open source 拥抱的脸 变形金刚. 一些视频分析可以通过基于时间卷积的长短期记忆(TCLSTM)网络来理解这一点.

Krefetz: 元数据终于得到关注了吗?

Crownshaw: 我见过的绝大多数决策者都选择修正他们的数据. 超过一半的人明白有必要改善他们的数据, 因为从长远来看, 这对他们有帮助, 不管他们是建立自己的模型还是利用别人的模型.

If you have really bad data, you’re going to ask it to compute more. The more efficient you can make it, the more you can reduce 计算 power required. 你还将消除一些你要求生成人工智能解决的复杂性.

Krefetz: 如何定义一个大型语言模型?

Crownshaw: 大型语言模型是一种人工智能,旨在理解从大量文本数据中学习到的类似人类的基于文本的模式. 通常, llm使用变压器架构等深度学习技术来处理和生成语言.

法学硕士的三个关键要素是规模、预培训和上下文理解.

An LLM is trained on a massive amount of data with a diverse range of topics and styles, 这能让你得到很多不同的答案. 大多数模型都经过了某种形式的预训练或微调以提高性能. 上下文理解意味着他们可以理解并生成文本,让任何看文本的人都能理解.

Krefetz: 如果您没有正确地完成这些训练阶段,或者没有正确地设置数据模型, 那么生成式人工智能将如何表现?

Crownshaw: 它会给你一些随机的结果. 我们与客户所做的很多工作都是基础数据模型工作,以提供用于音频的结构, video, 文本, 当你把这些多模态的东西拉回一起的时候(这样它就知道该怎么处理)一个字符列表, 场景, 和脚本.

我们首先限制我们使用的数据,使其始终从同一模型中提取. As people learn how to use the different types of prompts or data behind the 场景, they’re able to mitigate those hallucinations that may or may not occur.

Krefetz: Is there a standardized approach to data models, or does it depend on the company?

Crownshaw: 我从未见过一个适用于所有人的标准数据模型. 我看到很多客户都有不同的做法. 我上一家公司, 迪斯尼, 有他们所谓的“映射练习”,将通过所有不同类型的视频或内容的许多元素被创建,并通过过程映射它. (这将包括)它来自哪个相机的所有东西, 敬里面的人, 哪个场景, 等等......, and how they would lay that all out from a data model perspective. 但我一直认为这是一件非常定制的事情.

Because you’re dealing with a lot of old assets that have grown organically over time, it needs to be synthesized in a way that the large language models can understand. 你所看到的是,在过去的20年或30年里,由于需要快速获取内容,这些数据可能被忽视了. 现在它正在赶上他们, [and there’s a] need to go back and refine data so we can use these models effectively.

Krefetz: 你能谈谈其他一些资产管理方面的考虑吗?

Crownshaw: 显然,资产管理的计算成本很高. 处理和生成高分辨率视频摘要需要大量的百家乐软件, 所以以一种能让我有效、快速地吸收内容的方式来构建这些内容是很重要的.

使用生成式人工智能来查看最相关的内容,以及在哪里标记和使用它是至关重要的. 您确实需要部署和扩展服务. 然后还需要监视、记录和分析.

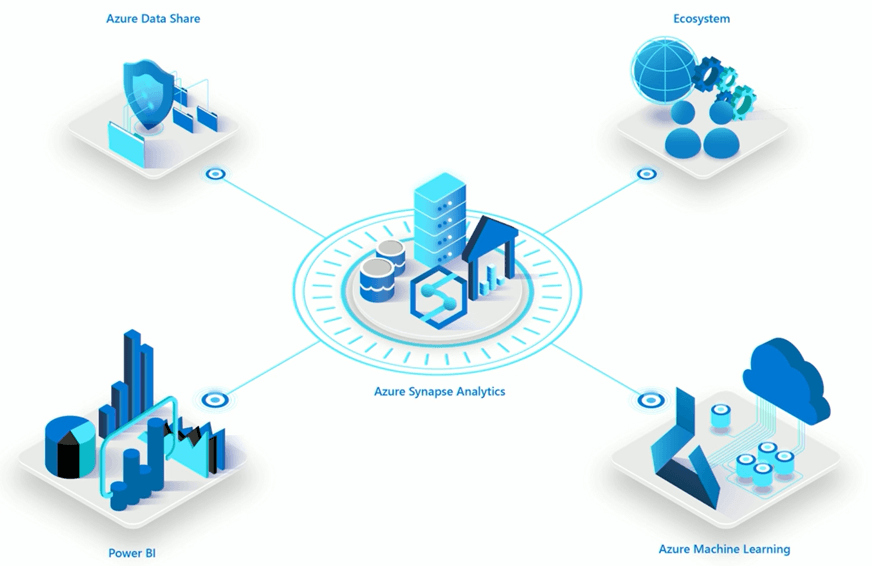

当你在这个过程中收集到更多的数据, 你需要分析来洞察这些模型是如何运行的,以及人们是如何与内容互动的. 可能是 微软Azure Synapse that helps you understand what’s going on with the data or maybe even 微软织物, 我们在哪里把多个数据源放在一起.

微软Azure Synapse

Krefetz: How does having content in multiple clouds impact 生成的人工智能 use cases?

Crownshaw: 越来越多的媒体客户正在使用混合方法, 将多个云与本地内容块结合在一起. 他们需要使用将所有这些整合在一起的服务,以便更实时地访问这些数据.

客户可以在AWS和Azure中拥有内容, 但在某种程度上, 我需要知道这一切是怎么运作的, 因为这有助于我理解工作流程和交付流程. 为此,微软提供了 Azure弧, which enables you to pull content and connect other pieces from other clouds.

微软Azure弧

我们还有 微软织物, which enables you to query data in AWS directly and have it all in one place. 你需要这种能力,因为很难移动数据, 进行所有这些基础设施和数据库更改. As those large language models get used more for things like asset management, 我们需要访问所有的数据, 即使它和其他东西不在同一个云中.

微软织物

Krefetz: 你的客户如何在内容交付中使用生成式AI?

Crownshaw: 在内容分发方面, 我们的编码伙伴, 和声与媒体, 和我们的一些客户合作,比如国际足联, 例如, 使用生成式人工智能实时动态调整流媒体质量和比特率,确保流畅的流媒体体验.

在中东,我们正在使用生成式人工智能模型将内容实时翻译和本地化为多种语言,以自动配音和字幕或删除单词(根据国家特定法规)。.

Krefetz: With adaptive bitrate encoding, what are the benefits of using 生成的人工智能?

Crownshaw: 生成式AI模型将分析大量内容,并理解具有复杂视觉效果或高动作的场景. 它可以预测这些因素是否有比特率要求, then dynamically adjust based on the content analysis that it’s already done. 如果模型检测到一个高动作的场景, it might recommend increasing the bitrate to maintain visual quality. Conversely, for static 场景, it might suggest lowering the bitrate to save bandwidth. 这不是典型的人工智能模型所能做到的. 这真的很新——生成式人工智能,它是动态完成的.

个性化体验, 该模型可能根据个人用户偏好或设备功能调整设置,并进行动态调整. 它还将进行网络状态监测. 在实时情况下,它可以预测网络拥塞并进行调整,而无需任何人做任何事情. The automation starts to kick in to minimize buffering or interruptions.它做的最后一件事是预测性缓存. 通常, 我们过去看到的是,你会试图了解是谁(验证了请求), 他们想要什么内容, 在哪里[最接近缓存内容], 但现在有了生成式人工智能, 我们可以使用历史数据和机器学习模型来预测内容需求,并以适当的质量水平预缓存内容, so it helps smooth the transitions between different bitrate streams.

Krefetz: 服务质量监控/交付是否比元数据创建更具成本效益?

Crownshaw: 我们现在可能处于一个不知道答案的阶段. I think the jury’s still out on whether one is cheaper than the other. 我们看到的是,就它们如何向前发展而言,每一个都将提供关键的收益和机会.

Krefetz: 让我们来谈谈流媒体内容推荐和最终用户体验,以及它们如何受到从传统人工智能到生成人工智能的转变的影响.

Crownshaw: 传统的人工智能已经使用了很长时间. 生成式AI是不同的. 有了生成式人工智能,在架构上,我们有:

- A massive data collection layer that understands how we interact with the content

- 元数据收集有关类型、演员、标签和所有其他信息的元数据

- 反馈数据,记录你我是否喜欢它

- 某种类型的数据处理层,用于理解所有交付的内容发生了什么

我们如何聚合所有这些部分,并在上面应用模型来提供建议? We did some of this during the Olympics, producing personalized elements. 你必须确保应用层能够提供个性化的体验, 你将需要一个庞大的基础设施层(通过Azure等云服务), 例如)来部署存储, 计算, 以及人工智能模型将所有这些结合在一起.

当用户观看和评价内容时,我们可能会看到收集到的交互数据. 一旦我们处理和分析了它,数据就干净了. 提取所有不同的特征, 并将相关数据输入生成式人工智能模型.

然后, 我们将使用该模型为新内容创建一个推荐引擎,同时生成动态缩略图和交互式内容. The user sees that personal recommendation and dynamic thumbnail, 然后当用户与之互动时,反馈循环就会完成,然后持续监控以改进AI模型.

That’s an example of how that 生成的人工智能 flow could technically work. 我们可以使用Cosmos DB进行数据收集, 用于处理的突触, 和Azure OpenAI模型本身. 对于应用层, 我们使用Azure前门, 哪一个可以完成所有的负载平衡和内容交付. We use Azure Monitor Log Analytics to collect and analyze that data, 然后我们可能会把这些都放到Azure上的Kubernetes服务中,来管理和扩展那些容器化的应用程序, including all of the models together so it runs in a streamlined architecture.

Krefetz: Is it easier to show ROI for some 生成的人工智能 use cases than others?

Crownshaw: For the NBA, we use a lot of their content to create custom highlights. Not only were we able to build that service, but we were able to build it faster. 可能需要2个月的时间,我们只花了2周甚至更短的时间. 我们看到浏览量呈指数级增长,从25万增长到10多亿. 人们可以更快地互动. The cost of doing that was exponentially less, but the return they were seeing was 3.5 - 4倍.

一个重要且相对直接的领域是利用媒体公司拥有的档案元数据,并确保它们能够被精简并快速地交付给客户.

现在,我们正在进行与十多年前围绕云计算进行的类似的讨论:“利用云计算可以提供的规模优势,我的内容和整个媒体流程是否更便宜??“今天, 我们谈论的是使用生成人工智能来获得新的管道和工作流程机会的投资回报.

答案是,我需要做的项目是相对较快地显示投资回报. 我可以扩展和完善架构(因为在过去的几年里,这些管道机会或流程从来没有足够的效率),以确保内容尽可能地交付. 数据模型的基础工作正在完成,以确保我们能够在正确的时间提供正确的内容.

Krefetz: 其他项目的时间框架是什么?

Crownshaw: 大型工作室和广播公司都有很多想要运行的用例清单,这些都有直接的管道机会, including the adaptive bitrate pieces we talked about previously. I would say we are down to days and weeks, and it’s happening significantly faster.

Krefetz: 安全方面呢??

Crownshaw: 从安全的角度来看, as we’re preparing the stream and getting the CDN components ready, 我们必须考虑安全因素. 很多工作室和流媒体平台, 安全性和遵从性部分将是最重要的,因此他们可以了解内容实际发生了什么以及如何保护它.

在某一时刻, we need to have model improvement and to have security throughout the entire process, 不只是在最后. 我如何确保它以正确的方式加密? 最后停在哪个站台? 它是从哪里来的? 我可以想象,生成式人工智能将在整个过程中得到更多的应用, 使它比过去更加自动化.

Krefetz: 您对大型语言模型共存有什么看法? 他们是竞争还是合作?

Crownshaw: I think what we’re going to see is more models having to work together. There’s not going to be one model that does it all; there are going to be many different types of models. Some models handle data, some handle 文本, some handle images, and some handle audio. They all need to be integrated for richer outputs in terms of how they work.

All of the models are going to get better based on the feedback loops, 他们接受的再培训, 以及他们能接触到的数据. That’s going to be an important process for 生成的人工智能 going forward.

Krefetz: 最后有什么想法吗??

Crownshaw: 我被客户问了很多问题,他们在考虑他们的管道架构将会是什么样子. 以下是管道架构需要考虑的阶段:

- Understanding the raw data input and what those model stages might look like

- 中级处理, which consists of outputs from those initial generations that need to be refined

- The feedback loops, to figure out which models work well together and which ones don’t

- 跨模型的集成, 也许在洁净室, 不同的模型会产生不同的输出.

- 一种元模型或聚合机制,用于将最终结果综合到易于处理的位置.

- 最后,是适合它的大型计算框架. 为流, 大规模的生成模型需要大量的分布式计算环境,利用gpu和tpu或基于云的平台(如Azure)来管理这些工作负载,并实现有效的模型训练和推理.

我认为独立的解决方案供应商最终会有他们自己的小llm. You can call those models through different APIs to refine different processes. 但我认为,随着这些模式的出现,接下来的几个月将会是这个行业的一个有趣的时期, 并且会有更多的API调用,以使这些模型可用于不同的流程.

相关文章

This article explores the current state of AI in the streaming encoding, 交付, 回放, 货币化生态系统. 通过了解发展并在评估人工智能解决方案时考虑关键问题, 流媒体专业人士可以做出明智的决定,将人工智能纳入他们的视频处理管道,并为人工智能驱动的视频技术的未来做好准备.

2024年7月29日

对于Anil Jain来说, 领导谷歌云的战略消费行业团队意味着帮助传统媒体公司拥抱云和人工智能, 转向以opex为中心的商业模式, and adapt to a more development-oriented mindset in engineering and product management. 在这次采访中, Jain discusses the global shift to cloud-based operations in the media industry, 从生产到包装再到用户体验的各个方面,生成式人工智能正在颠覆一切, and what media companies should be afraid of if they're not already.

2024年6月12日

将生成式人工智能整合到我们的工作流程中有可能影响媒体技术中的几乎所有内容, 我将在本文中研究几种可能性.

2023年10月4日